24/11/2008

La Grande Gaufre (00)

L’Informatique sous un angle insolite et insolent

Préface: Pourquoi une gaufre en parlant d'informatique?

« Informatique : Alliance d'une science inexacte et d'une activité humaine faillible. », Luc Fayard

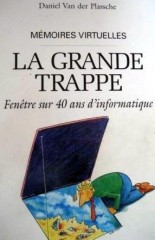

Je me souviens d'un bouquin écrit, en 1996, par notre "General Manager" local, à la retraite. Il parlait des entreprises du secteur informatique qui grandissaient et s'effaçaient une à une, soit absorbées, soit emportées dans la course à la technologie.

Je me souviens d'un bouquin écrit, en 1996, par notre "General Manager" local, à la retraite. Il parlait des entreprises du secteur informatique qui grandissaient et s'effaçaient une à une, soit absorbées, soit emportées dans la course à la technologie.

Il avait titré son bouquin "La Grande Trappe".

Sa réflexion a été pour l'occasion : "Je vais écrire un livre sur l'histoire de l'évolution des ordinateurs, et je vivrai de ce que les constructeurs me payeront pour que je ne publie pas mon livre ".

Les années qui ont suivi son départ, se sont montrées, non moins voraces, mais sous un autre jour qui ressemble plus à une «Grande Gaufre» par certains points de vue.

Les développements plus ou moins chronologiques ne sont pas une exclusivité du secteur. Elles jouent avec les mêmes armes et les mêmes travers, mais souvent, elles l'ont fait avec plus de zèle, plus ciblées, dans un degré d'excitation et une urgence très personnelle. Si les initiales "ADM" vous disent quelque chose, cela pourrait être un parallèle.

Je reprendrai, en le résumant, le bouquin de mon illustre GM qui a traversé l'histoire de 40 ans d'informatique avec une vue "managériale". Cela me servira de fil rouge pour en reprendre une vision plus personnelle, par l'autre bout de l'échelle, celle de la base.

Si l'histoire officielle vous intéresse seule, elle est, peut-être, sous ce lien, sous la forme d'une autre histoire sous Internet trouvée avec l'aide de Wikipedia.

Expliquons d'abord le titre. Choix volontairement allégorique, en effet. Une gaufre, parfois plus caustique ou plus sucré, selon le cas. Le parallèle entre la représentation allégorique et ce qui s'est déroulé, je le ferai au cours du "show".

Au début, il y a avait la pâte fine destinée aux gaufres: avec une technologie toute fraîche, qui montait sans rien faire, toute pleine d'espoir. La volonté était de la produire au plus vite pour supprimer les tâches répétitives. Toute faite de calculs, de réflexions, de textes intégrées. Une belle pâte fraîche, quoi....

Au début, il y a avait la pâte fine destinée aux gaufres: avec une technologie toute fraîche, qui montait sans rien faire, toute pleine d'espoir. La volonté était de la produire au plus vite pour supprimer les tâches répétitives. Toute faite de calculs, de réflexions, de textes intégrées. Une belle pâte fraîche, quoi....

Cette pâte était montée sans beaucoup d'efforts, avec un peu de levure, avec des produits nouveaux conçus "maison". Tout avait, encore, à être inventé. Pour cela, il y avait des créateurs hors pair. Les nouveautés successives avaient pour tâche d'effacer les ratés des opérations manuelles, pour effacer leurs fragilités, leur lenteur d'homme. Beaucoup de contraintes et de mauvaises initiatives toujours destinées à répondre au seul progrès se présentèrent en vrac, sans beaucoup d'expériences préliminaires. La pâte, gorgée de levure, après sa phase ascendante, ne pouvait jamais monter plus haut que le récipient qui la contenait. Mais personne ne s'en souciait. En fin de course, même les nouveautés s'épuisaient. On apprenait ce principe en s'apercevant que rien n'atteint le ciel qu'après beaucoup de temps et d'argent. Mais, n'est ce pas la même chose. Le "Think" d'IBM n'était qu'un sommet parmi beaucoup d'icebergs. On fonçait, on travaillait sans compter, sans limites, trop enthousiasmés par le goût sucré de la nouveauté. L'avenir tout entier était dans les mains des audacieux et les nuits gonflaient les espoirs.

Toute dorée, au début de ce siècle, une bulle s'était formée au sommet de cette pâte encore molle. Les excès du progrès avaient usé les gaufriers les mieux conçus, les mieux aguerris contre la concurrence. Le "hardware" restait sujet à certaines convenances limitées par les potentiels de production des fournisseurs et de l'absorption par la clientèle.

Cette dernière, il ne suffisait plus de l’appâter, il fallait la gâter, la gaver de sucre jusqu'au diabète par le "customer focus", qu'on signalait, simplement, pour ne pas se faire distancer par les "autres".

Petite d'abord, la bulle s'était enflée entraînant la pâte bien molle sur les bords du récipient. Très vite, pourtant, poussée par ses suivantes, la pâte s'était mise à se répandre un peu partout sur les bords du gaufrier, d'abord. Sur le plan de travail, ensuite. La confusion générale, la surprise la plus totale s'en était suivie. On épongeait, on essuyait sans relâche. "L'informatique gaufrière", fonctionnelle avec un avenir certain suivant la compétition acharnée et annoncée. Mais en secret, elle avait subitement pris du plomb dans l'aile. "Qui trop embrasse, mal étreint", pensait-on. Il fallait consolider l'ensemble. Les producteurs venaient de partout, de tous les horizons de l'activité humaine et semblaient intéressés. On se bousculait au portillon jusqu'à oublier où était le "core business", le cœur des petites affaires. Tous les clients voulaient goûter les dernières gaufres, produites avec le plus d'assiduité, le plus d'assurance et au plus bas prix. On était même prêt à participer à la production pour accélérer le processus ... Ou pour le ralentir, qui sait?

Cela fera partie de ce qu'on appellera le "marketing viral".

Car, l'avenir de cette gaufre n'était-il plus totalement assurée qu'on le disait. Le prix de la pâte se payait de plus en plus cher, dès sa sortie. Le gaufrier, lui, avait été perfectionné de gadgets tout azimut le rendant automatique par touches successives. La "gadgetisation", le "user friendlyness" n'avaient pourtant pas été gratuits.

Au sujet des trous dans la gaufre, les uns les voulaient carrés, les autres ronds. Les habitudes qui devaient se réorienter en permanence, demandaient de plus en plus d'heures d'apprentissage pour assurer un tant soit peu d'expérience.

On "versionnait" les gaufriers. Ce fut d'abord les séries qui sortaient et qui ne nécessitaient qu'un ajustement de dernière minute. Bien plus tard, ce furent les programmes d'utilisation qui suivirent le même cheminement avec la complexité qui s'amplifiait. On supprimait ou sauvait des emplois du côté de ceux qui étaient chargés de la confection des gaufres. On créait de nouvelles fonctions, des concepteurs de gaufriers, par la même occasion. Ils changeaient de nom et rataient quelques marches et quelques trous.

Ce furent l'invasion des designers. Que pouvait-on faire de plus et de mieux?  Et pourtant... il fallait le retenir cet automatisme qui ne cherchait plus qu'à trouver un hypothétique besoin de progrès.

Et pourtant... il fallait le retenir cet automatisme qui ne cherchait plus qu'à trouver un hypothétique besoin de progrès.

On se copiait aussi. On fantasmait surtout.

On imaginait toutes les formes du succès.

On découvrait que la petite gaufre carrée, cela prenait moins de place dans l'emballage et pouvait intéresser d'autres acheteurs qui adoraient aussi le sucré-salé.

Le packaging était né. L'espionnage n'a jamais été une affaire de guerre ouverte. On s'observait pour, seulement, en trouver la substantifique moelle et pour, tout aussi vite, l'adapter à sa propre réflexion après l'adaptation de l'étiquette. Bien loin du stade du gros oeuvre, le look de l'appareil prenait de plus en plus d'importance en oubliant sa fonction de base: "faire des gaufres". Windows, la fenêtre sur le monde, ne fut qu'un des solvants de l'approche de convivialité.

"Comment fidéliser sa clientèle?" était devenu la question la plus lancinante pour tous, l'un après l'autre. Les plus grands qui avaient une avance, un seul "gap" avec les suivant rejoignaient tout doucement le troupeau.

Personne ne se posait encore, avec courage, la question du pourquoi pousser le développement dans certaines voies limites, mais il le fallait pour les consommateurs. Le calcul du ratio prix-performance, du P&L, seul, comptait faire des gaufres les plus dorées et les plus croustillantes possibles au meilleur prix performance et meilleure que la concurrence. "Vaincre ou mourir", devenait la devise.

En bas de l'échelle de production, du moment que le chef de la « boîte à gaufres » était content, tout allait bien, se disait-on. Cette course en avant fut entreprise en oubliant qu'à un moment, le coût de la production de ces gadgets dépasserait celui de la vente vu les investissements. La courbe de la rentabilité ne devait que redescendre après l'arrivée à cette apogée que personne ne décelait vraiment.

La bulle des années 2000 (en informatique, juste pour rappel) n'était que la remise à l'heure du processus.

Les apprentis sorciers en ont été pour leurs frais: les gaufres n'ont plus eu le goût de gaufre et la clientèle n'adhèrait plus par contrat. La pâte était produite au prix le plus bas. Les pâtissiers de première couche, devenaient payés au plus juste prix et rongeaient leur frein. Des pâtissiers, trop spécialisés pour rester en course quittaient mais, en s'éclipsant, contraint ou forcés, ils faisaient perdre les généralités du processus global de production qui se perdaient dans les oubliettes.

Financière et boursière, cette allégorie "pâteuse" rappelait les crisettes ou les véritables crises de confiance qui s'étaient déjà manifestées envers la science et les progrès technologiques.

Fracture numérique, qu'ils disaient. Eux devaient tout régler pour le progrès et le bien être de l'homme futur. Pour la bonne bouche mais sans bouche à bouche. Cette phase se préparait pourtant.

Avec la pâte qui restait dans la casserole, il avait fallu se résoudre à en faire des gaufrettes, toujours plus petites, avec de levure plus exotique.

Le prix de la levure montait dans le même temps. Les produits qui la composait se perdaient dans la nuit des temps. Beaucoup de déchets étaient à déplorer. On ne saura jamais si ce qui était passé à la poubelle de l'histoire, l'avait été à bon escient, mais il avait fallu choisir dans la précipitation. Les poubelles se retrouvaient dans le chemin inverse d'où elles venaient pour garder un tant soi peu de valeur dans le recyclage.

Les prix de la matière première et des ingrédients étaient devenus tellement chers, le gaufrier, tellement bon marché, les manutentionnaires dont on n'espérait un peu trop que respecter les dates de péremption très lointaines, que tout devenait aléatoire. Décongelée, la plus brutale. On pressa, de plus en plus fort, les deux plaques du gaufrier. On pressa, compressa pour atteindre le minimum d'espace entre les plaques du coût. On avait presque créé des churros ou des croque-monsieur en place des gaufres. Un peu secs, les churros... mais ceux qui s'en plaignaient, c'était ça ou la fuite vers une herbe qui n'était pas plus verte ailleurs.

Parfois, au mauvais moment, un court circuit se produisait. Les grèves du zèle, les fameux "bugs", étaient nés et faisaient des ravages dans la fine mécanique. Nombreux, ces bugs. Internes et externes. La gaufre était alors devenu trop brûlée sur le haut et pas assez sur le bas. Il fallait remplacer ou c'était le chômage technique et l'info qui ne passe plus. Changer les gaufriers dans leur structure, changer la pâte et les fournisseurs devenait les seules préoccupations. Cela prenait de plus en plus de temps pour faire le produit fini : la belle gaufre. Le "snacky gaufrier", d'autres appelaient cela PC, était devenu le futur immédiat et pour longtemps.

Tester se faisait, cette fois, à distance. En réseau, qu'on disait. C'était un peu l'aventure que l'on se refilait sans beaucoup d'expériences. Le gaufrier, on l'emportait à la maison. L'esprit d'équipe s'y perdait, mais était-il prépondérant, puisque tout le monde y gagnait un peu? C'était oser se tromper et partir en perdition dans certaines mauvaises gestions du risque. Le meilleur rapport se cantonnait en définitive à la seule norme du prix bas en n'oubliant pas la performance, mais tout de même un peu la gestion dans l'efficacité, en finale. Pour comprendre les desiderata de la clientèle et des prospects, Internet va offrir d'autres formes d’espionnite. Nouvelle appellation, le "fishing" en réseau allait apporter une source d'informations infinie sur le consommateur. Du poisson dans les gaufres !!! Un comble. Ensuite, les consommateurs, eux-mêmes, s'offraient au monde du virtuel par les blogs et des "ego" soigneusement détaillés, retrouvés sur les MySpace et autres. Comme compensation, on naviguait en plein "réseaux social". Parfois, le producteur, lui-même, scannait, plus ou moins incognito, derrière des pseudos, à la recherche de ce qui manquait pour s'attirer l'eau de Jouvence à mélanger avec la pâte.

Dans cette débandade de la gaufrette, prenant encore d'autres formes épiques, à en oublier jusqu'à l'origine et la finalité : plaire au client. La chantilly, au sommet de la gaufre, placée pour agrémenter, n'était plus tout à fait blanche et fondait de plus en plus vite.

Dans cette débandade de la gaufrette, prenant encore d'autres formes épiques, à en oublier jusqu'à l'origine et la finalité : plaire au client. La chantilly, au sommet de la gaufre, placée pour agrémenter, n'était plus tout à fait blanche et fondait de plus en plus vite.

Personne ne s'inquiétait plus que le gaufreur ne porte plus la toque sur la tête. Quant au pâtissier, censé seulement de placer la pâte dans le gaufrier, la motivation s'en allait comme elle était venue. La qualité laissait tout doucement à désirer vu la compétition trop virulente. Elle faisait place à la quantité. On n'allaient jamais assez vite. La notion du temps nécessaire était très suggestive et les déchets s'accumulaient. On allait chercher ailleurs, de plus en plus loin, si la pâte était meilleure, si l'ensemble des opérations ne pouvait s'y dérouler, en plus. On en perdait son âme et sa marque. La technologie, au service de la technique et plus l'inverse.

Les clients, les grands amateurs de gaufres, étaient de moins en moins contents. Changer trop souvent, on n'aime pas trop dans ce milieu très terre à terre, trop peu pragmatique. A chacun sa gaufre. La patience et le travail des plus acharnés ont été les secours de ceux qui espéraient encore, de ceux qui restaient à bord, ce qui n'était pas nécessairement une chance après coup. Ce qui restait à l'intérieur s'était vu prendre des formes très coincées, très moulées dans un style "tout fait", pas très séant. Les clients avaient eu même l'audace de passer leur tour.

Le goût n'était manifestement plus le même avec le design tout fait. Pour s'en rappeler, on y accolait un numéro de série sur le dessous, un "serial number", qu'on disait pour ne pas confondre. On se mettait à rêver de jours meilleurs.

Où avait-on raté les marches? Une mauvaise adaptation aux besoins réels du client, une mauvaise appréciation du côté fournisseur, un manque de motivation pour les études "gaufrières"? Créer une pénurie pour les amateurs pour relancer la machine? Tout n'était qu'affaire de cycles, disait-on. A un creux d'une gaufre, correspondrait, pour un temps, une excroissance en alternance plus qu'honorable mais, cette fois, plus dans l'unanimité. On dénombrait plus de creux que de gaufres. Heureusement, le pensait-on, on avait appris et pris des dispositions de sauvetage, les mieux ajustées possible. Pourquoi pas modifier les constituants de la pâte? Affiner les ingrédients et s'inquiéter pour maintenir la pâte dans la casserole pour ne pas en perdre.

L'école pouvait remotiver les troupes pour remettre toute la "machinerie" en route. Les études pour devenir gaufreur étaient devenues aussi de plus en plus complexes. Ce n'était plus le dessert que l'on se servait à quatre heures. Les pâtissiers qui avaient quelques qualifications plus spéciales, s'échappaient vers des horizons les plus variés. Cela en devenait gênant car les gaufres, on en redemandait aussi en anciens formats. Les clients n'en feront jamais qu'à leur tête.

Aromatiser la gaufre pressée avec le flambé d'un « alcool de riz » allaient pour un temps, en améliorer le goût. Enfin, on l'espérait. Cela mènerait peut-être à devoir acheter des gaufres à la grande surface, empaquetées, plastifiées avec de petits caractères parfois illisibles sur l'emballage. Tout est une question de mesure, en somme.

Des ordinateurs, pour en revenir à eux, c'est un peu leur histoire avec ses hauts et ses bas.

Cette histoire, un subtil mélange de pâte, de gaufres, de gaufriers, de gaufreurs, de gaufrés, de "bits", de dichotomies digitales. Elle est loin d'être finie.

Vous n'avez pas tout compris dans ce monde onirique? Normal, c'était volontaire.

Le détail se retrouvera dans les chapitres suivants.

Se rappeler seulement qu'une gaufre est un dessert avec des creux et aussi des rebondissements des processus par secousses répétés sur toute sa surface.

Le virus "argent" a toujours motivé plus en tout, même si la passion du travail s'est réduite. Le bonheur du travail bien fait est un peu à la traîne. La chaleur est toujours là, latente, il suffit de la maintenir à feu doux pour la ranimer.

Critiques, parfois acerbes, que tout cela?

Il faut être critique. Si les informaticiens ne l'étaient pas qui le seraient. La profession d'invention qu'est celle d'informaticien, les besoins de progrès toujours en expansion en valent la peine.

Attachez, donc, vos ceintures sans nostalgie et avec ou sans abandonware car cela va secouer...

Pas trop de levure, à feu doux, sans trop d'agitation, disais-je, et elle sortira, cette gaufre, bien dorée et croustillante.

Alors, que dire de plus , sinon, "Bon appétit".

18:20 | Lien permanent | Commentaires (1)

23/11/2008

La Grande Gaufre (01)

Tableau 1:"L'irrésistible ascension"

« Le cycle d'obsolescence des ordinateurs est devenu si rapide, que dans les hypermarchés informatiques du futur, il y aura des décharges justes en face des caisses enregistreuses. », Dave Barry

Le survol de l'histoire officielle des 40 premières années de l'informatique se passa, au départ, par la mécanographie.

Reprenons quelques chiffres du bouquin d'histoire du GM qui commençaient en 1945 et s'achevaient vers 1995.

Le coût horaire moyen d'un employé administratif et la capacité de stockage, deux méthodes pour évaluer la réduction du prix pour le traitement de l'information et les performances entre deux domaines distincts.

En 1945, le coût horaire d’un employé modèle équivalait à 1000 opérations arithmétiques sur la calculatrice électromécanique et en stockant 150 fiches imprimées. Le prix d'acquisition d'un ordinateur d'alors était amorti sur 9000 heures.

En 1945, le coût horaire d’un employé modèle équivalait à 1000 opérations arithmétiques sur la calculatrice électromécanique et en stockant 150 fiches imprimées. Le prix d'acquisition d'un ordinateur d'alors était amorti sur 9000 heures.

En 1960, cette même heure de travail correspondait, déjà, à l'agitation d'1,4 millions d'instructions ou de 5 millions de caractères sur disque magnétique.

En 1980, l'équilibre dans la balance "énergétique" s'établit avec quelques 250 millions d'instructions et 40 millions de caractères, pendant 5 heures.

En 1995, le même calcul mais, pour 3 milliards d'instructions et 1 milliard de caractères archivés.

Depuis, l'exponentiation a continué de plus belle. La taille des machines s'est réduite sans rien perdre en efficacité.

Depuis, l'exponentiation a continué de plus belle. La taille des machines s'est réduite sans rien perdre en efficacité.

Dès le début de l'ère informatique, l'algèbre booléenne rentrait dans la cour des grands après une longue période de sommeil. Herman Hollerith n'avait pas encore reçu les honneurs dus à son rang avant cette entrée fracassante dans l'informatique. Le 2 juin 1890, Hollerith crée la première machine à cartes perforées. Objectif, recenser la population. Inspiré par les métiers Jacquard, Hollerith qui travaille dans le recensement, invente une machine électro-magnétique qui utilise des cartes perforées. Comme elle est dix fois plus rapide que ses concurrents, il remporte le concours en 1889 lancé par la ville. Après quelques passages de noms de société, le nom IBM en ressortira.

Big Blue, IBM, fête son 100ème anniversaire en 2011. La société CTL (Computing Tabulating Company) est en effet créée en 1911. On la rebaptise en 1924 par IBM (International Business Machine). Elle vend d'abord des horloges industrielles, des tabulateurs. En 1944, c'est Mark1 qui sort en tant que calculateur analytique électromagnétique. En 1945, Mark2 apporte ses circuits en grilles. Le mot "bug" est né à cette époque à cause d'un insecte qui grille les circuits et provoque une panne. En 1953, le Modèle 650 sort d'usine et c'est le mot "ordinateur" qui prend jour en France. En 1956, le fondateur Watson meurt. Tom, son fils, reprend l'affaire. En 1957, le RAMAC 305 sort le 1er disque dur (50 disques magnétiques et 50 Mbytes de contenance), le Fortran devient le langage scientifique. Tout s'emballe ensuite. L'âge d'or verra son apogée en 1985. Microsoft et Intel lui volent la vedette. n 1993, ce sont 8 milliards de pertes. En 2002, une renaissance se présente la tête dans les nuages (cloud computing) et les pieds en Asie.

Big Blue, IBM, fête son 100ème anniversaire en 2011. La société CTL (Computing Tabulating Company) est en effet créée en 1911. On la rebaptise en 1924 par IBM (International Business Machine). Elle vend d'abord des horloges industrielles, des tabulateurs. En 1944, c'est Mark1 qui sort en tant que calculateur analytique électromagnétique. En 1945, Mark2 apporte ses circuits en grilles. Le mot "bug" est né à cette époque à cause d'un insecte qui grille les circuits et provoque une panne. En 1953, le Modèle 650 sort d'usine et c'est le mot "ordinateur" qui prend jour en France. En 1956, le fondateur Watson meurt. Tom, son fils, reprend l'affaire. En 1957, le RAMAC 305 sort le 1er disque dur (50 disques magnétiques et 50 Mbytes de contenance), le Fortran devient le langage scientifique. Tout s'emballe ensuite. L'âge d'or verra son apogée en 1985. Microsoft et Intel lui volent la vedette. n 1993, ce sont 8 milliards de pertes. En 2002, une renaissance se présente la tête dans les nuages (cloud computing) et les pieds en Asie.

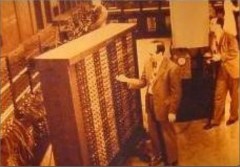

John Atanasoff avait construit le premier ordinateur électronique, nommé ABC (Atanasoff-Berry Computer) en utilisant le système binaire. L'ENIAC (Electronical Numeral Integrator And Computer), développé par Eckert, Mauchly et von Neumann, considéré comme le premier ordinateur, se voyait détrôné de cette première place après un procès en 1970. Elle contenait 18.000 lampes. Poids total 30 tonnes. 150.000 Watt de consommation. Vitesse : 5.000 additions ou 300 multiplications ou 40 divisions par seconde avec 200.000 Hz. Le contexte, l'armement nucléaire pour évaluer plus rapidement les tables balistiques.

Recenser la population américaine avait de quoi énerver par son côté mécanique et peu glorifiant de l'époque. Pour établir des statistiques, des cartes perforées Hollerith avaient déjà été utilisées dès 1890. Autre chance pour l'ENIAC.

L'information allait résider cachée dans des trous ! En 1951, UNIVAC était le nom de cette machine à statistiques. Le département de la Défense n'était pas loin du développement.

Le génial mathématicien, Alan Turing fonde la science informatique et avec sa "machine de Turing", le Colossus ou Enigma, permet de casser les codes secrets allemands pendant la seconde guerre mondiale. Une article "Computable Numbers with an Application to the Entscheidungsproblem" le met en piste avec un algorithme qui s'exprime dans le langage formel pour donner une réponse par "vrai" ou "faux" aux expressions mathématiques et à la pensée abstraite de la logique. Il a l'idée de l'universalité d'une machine pensante, en véritable "computerwizz", qui pourrait servir pour tout. Le "test de Turing" lui permet d'aborder l'Intelligence Artificielle. Il crée le premier programme pour jouer aux échecs mais, face à une machine trop lente, ne lui permettra pas d'arriver à ses fins. Il meurt à 42 ans en croquant une pomme empoisonnée au cyanure. Cette pomme se retrouve-t-elle dans le logo de Apple? Peut-être, pas officiellement. Il faut garder des légendes. Une statue lui a été dédiée en 2002 à Manchester. On peut y lire, gravé : "Lorsqu'on les considère avec justesse, les mathématiques ne possèdent pas seulement la vérité, mais aussi la plus grande beauté, une beauté froide et sévère comme celle d'une statue".

Peut-on tout calculer? Un question à son sujet dès le départ.

En 1948, John Bardeen, William Shockley et Walter Brattain inventent les transistors. En 1958, Jack Kilby les insère dans des circuits intégrés.

Dans les années 70, les États ont accompagné et contribué mais sans s'impliquer dans la construction elle-même de ces nouveaux bolides véhiculant l'information. Sage précaution, peut-être, vu la complexité, les mutations incessantes et la rentabilité dégressive dans le temps.

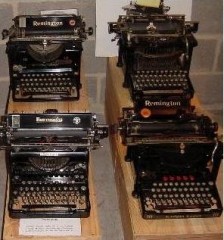

Un peu plus tard, seulement quatre entreprises se partageront le marché: IBM, Remington Rand, Bull et ICL.

L'ordinateur relié à l'homme par l'intermédiaire des cartes perforées ou de bandes magnétiques suivant le choix de l'entreprise en fonction des fournisseurs de périphériques.

La progression de cette industrie va dépasser toutes les espérances de l'imagination. RCA, Honeywell, NCR, Burroughs, Control Data, Siemens, Nixdorff, Wang, Olivetti, Digital vont entrer dans la danse, dans un marché dont il semblait y avoir de plus en plus d'avenir mais dont on sous-estimait les budgets de développement pour venir à bout de la complexité. "Semblait" car personne n'en était convaincu.

Le 1er numéro de la revue d'informatique Datamation, parue en 1957, ne contient aucune publicité pour une marque d'ordinateur. A l'intérieur de ses pages, des connecteurs, des câbles, des oscilloscopes seuls ont ce privilège. L'Université de Chicago va construire un "analogic computer". Cela intéressera le secteur des télécommunications, sans plus, pendant un demi-siècle. Les impulsions éclectiques et électroniques sont utilisées pour calculer par l'intermédiaire de graphiques. Mais étant trop spécialisées et avec une précision douteuse, elles disparaissaient pour d'autres utilisateurs, plus tournés vers la comptabilité et la précision. Première opposition entre analogique et numérique qu'on appellera ensuite la "fracture numérique".

Le patron de RCA parlait déjà d'input pour les machines par l'intermédiaire de la voix. Troublant quand on reconnaît les problèmes de ce côté, encore aujourd'hui.

Les concepts de données à l'entrée, de mémoire, du processing interne et des résultats imprimés concentraient toutes les applications contrôlées par la suite logique d'un programme mémorisé, prêt à répéter indéfiniment la même séquence d'instructions, avant de trouver sa sortie. La période de mécanographie programmait ses programmes par l'intermédiaire de fils électriques enfichés dans un tableau et passaient au travers de tabulatrices. Un programme par tableau. Ensuite, par programmes intégrés dans la machine sous formes d'instructions enregistrées, les tores de ferrites constituèrent, dès lors, la nouvelle mémoire interne.

En Europe, l’année 1958 a vu les premières machines IBM de manière plus distrayante. L'Expo Universelle 58, à Bruxelles, ouvrait cette ère du virtuel. On comptait encore en gain dans le domaine du calcul pur avec vue sur la comptabilité. Le progrès de la puissance du calcul donnait le tournis aux visiteurs de l’Expo. On gagnait la confiance pour un futur enchanté. Dans le même temps, la machine faisait peur au management des premiers utilisateurs, au point d'être rejetée dans la plus grande panique, peur de ne plus pouvoir assumer le travail d'antan.

Beaucoup de comptables, « rond de cuir », d'employés de l'administration ont disparu avec la peur de ce lendemain qui effrayait, avec ces machines du diable, poussés par la direction. Bouleversements, convoitises se sont succédés à un rythme de plus en plus accéléré.

Beaucoup de comptables, « rond de cuir », d'employés de l'administration ont disparu avec la peur de ce lendemain qui effrayait, avec ces machines du diable, poussés par la direction. Bouleversements, convoitises se sont succédés à un rythme de plus en plus accéléré.

Mécanographie, facturières, traitements de textes étaient bien dissociés sur des machines différentes.  Tous les secteurs de l’entreprise et de la science vont pourtant se recentrer et adopter une machine unique aux fonctions multiples.

Tous les secteurs de l’entreprise et de la science vont pourtant se recentrer et adopter une machine unique aux fonctions multiples.

Véritable tournant de l'histoire de la mécanisation pré-informatique, le 1401 d'IBM, ordinateur à transistors, allait faire sensation au niveau du nombre inattendu de commandes avec des délais de livraison qui s'allongeaient sur 2 ans.

Des migrations, vers cette machine, se pressèrent grâce à une programmation relativement simple mais limitée de cette machine louée souvent à titre précaire. Mémoire : 1400 caractères ou mots extensibles à 4000, sans Operating System, câblés dans des circuits électroniques. Fonction principale : imprimante évoluée. Les concurrents vont, alors, réaliser les premiers "systèmes compatibles" avec un peu plus de mémoire. Un exode partiel s'en est suivi au niveau clientèle et personnel. Rien de grave, pourtant.

En 1964, l'IBM 360, compatibles entre modèles, avec ses circuits intégrés, ses logiciels interchangeables et ses périphériques, fut la première machine à faire le travail de complémentarité abordant à 360° la plupart des problèmes de gestion. Complète et aussi extensible en fonction des besoins grandissants des clients, cette machine révolutionnait en remplaçant toutes les précédentes trop spécialisées. Le succès fut total et inespéré. On allait s'arracher ce 360 avant les autres.

En 1964, l'IBM 360, compatibles entre modèles, avec ses circuits intégrés, ses logiciels interchangeables et ses périphériques, fut la première machine à faire le travail de complémentarité abordant à 360° la plupart des problèmes de gestion. Complète et aussi extensible en fonction des besoins grandissants des clients, cette machine révolutionnait en remplaçant toutes les précédentes trop spécialisées. Le succès fut total et inespéré. On allait s'arracher ce 360 avant les autres.

Une conspiration du silence allait seulement permettre ce succès. Si le hardware était bien beau, le software l'était beaucoup moins. Inachevé, ce dernier allait d'ailleurs faire partie du prix de la machine, faute de mieux. Les programmes étaient inclus ou à développer, à installer en même temps que la machine avec les concours des clients. Le client était devenu, une première fois, l'otage compatissant du fournisseur.

Dès lors, la concurrence allait se sentir obligée de se rendre compatible avec ce fameux "360" pour espérer attaquer une part du marché.

Siemens 4004, Univac 1100, le CDC 6600, B2500 de Burroughs...et autres (r)évolutions, des mini costauds, mais qui en font un maximum, le PDP8 de Digital Equipment associé à l'industrie suivait dans cette bagarre. Les applications "clé sur porte" se pontaient à l'horizon.

Les machines étaient louées à l'année pour rester abordables financièrement pour le client mais aussi pour rester dans la course du progrès qui évolua à vitesses soutenues par la force explosive de calcul et concrétisées aussi par les rentrées d'argent dans les caisses du constructeur.

Des clients, se sentant, tout à coup, trop liés aux locations, toujours plus chères, entamèrent des procès en justice pour pouvoir acheter le matériel. Bon ou mauvais calcul ? Ce qui était plus gênant, c'est que certains équipements "exotiques", disques, bandes magnétiques, commençaient à se greffer sur cette machine de base louée en s’y intégrant plus ou moins bien. Les premiers compatibles se furent les périphériques.

IBM devait réagir. Il fallait fidéliser. Les concurrents se faisaient de plus en plus agressifs. Répondre aux procès anti-trust qui commençaient à tomber, devenait impératif. Lancé le culte d’IBM dans la tête des représentants de la firme et, par ricochet, dans celle des clients. L'image avec le son de la renommée. Le choix d'un constructeur comme IBM se faisait à base de publicité, de matraquage médiatisé. Une réputation parfois surfaite mais qui se perpétrait par une vénération en interne et en externe à la firme.

L'unbundling (le dégroupage de la machine, des programmes et des services) sauva une partie des "meubles", du hardware. Ce qui était gratuit et compris dans le prix auparavant, allait devenir, tout à coup, payant. Le client remarquait bien que l'ardoise de tous ses besoins dépassait le "bundling" (machine et programmes), mais le pli était pris. Le software prenait, tout à coup, du galon dans la configuration par l'entremise de licences pour compenser le manque à gagner.

En 1968, un procès anti-monopole, anti-trust, essaya d'effacer cette caricature de "Blanche Neige et les sept nains" d'IBM avec Burroughs CDC, GE, Honeywell, NCR, RCA, UNIVAC. Ceux-ci se rendaient progressivement compte que les places étaient devenues chères et que les investissements ressembleraient à la grenouille qui voulait se faire aussi grosse que le bœuf.

Mais, le thriller ne faisait que commencer dans les hautes sphères.

Dans le prochain épisode, flash-back sur la vision par le bas de l'échelle, celle des informaticiens et de ss utilisateurs.

Contrairement à celle des constructeurs d'équipements, je pourrais la surnommer d'"L'âge d'or".

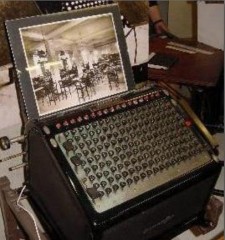

(Les photos ont été prises dans le Musée de l'Informatique constitué chez Unisys à Bruxelles)

18:18 | Lien permanent | Commentaires (2)

22/11/2008

La Grande Gaufre (02)

Tableau 2: "L'âge d'or"

« Nous autres, mordus d'informatique, préférons par-dessus tout passer notre temps à bidouiller nos ordinateurs, plutôt que les utiliser pour faire quelque chose de productif. », Dave Barry

Retour vers les débuts de l'informatique, avec, cette fois, une vision parallèle, par la base des hommes, des informaticiens, des utilisateurs, des néophytes, parfois, faces à de vrais ou de faux gourous.

Retour vers les débuts de l'informatique, avec, cette fois, une vision parallèle, par la base des hommes, des informaticiens, des utilisateurs, des néophytes, parfois, faces à de vrais ou de faux gourous.

L'informatique n'a pas créé que des heureux chez eux. Loin s'en faut et, cela fut très dépendant des points de vue en présence.

L'ordinateur se voyait certainement comme un destructeur de l'emploi, comme toutes machines qui surprime beaucoup de professions. Il allait bouleverser les habitudes et les méthodes de travail. Pour d'autres, c'était une chance donnée au progrès.

Alors, comment s'est faite la transition entre le travail humain et celui réalisé par la machine ? Quelle infrastructure s'était construite pour assurer la mise en place et le suivi de l'opération "informatique"? Pas de moralité, à chercher dans le processus.

L'enseignement, d'abord, bien entendu. Mais, aucune école officielle n'existait pour enseigner les bases de cette énigmatique "mécanographique ou informatique" qui se pointait à l'horizon et cette "science" du même nom, dans laquelle personne ne voyait un réel futur de manière durable.

Ceux qui pensèrent qu'il y avait des débouchés, le ressentirent, comme tel, sans véritable fougue et avec, seulement, une grande curiosité.

Il fallait avoir un esprit visionnaire, avant-gardiste, et peu enclin à la sécurité d'emploi à tout prix pour se lancer dans l'aventure. Il fallait surtout se former sur le tas en pionnier. Pas d'expérience, pas de professeurs formés pour diffuser la "bonne parole" en deux digits, le 0 et le 1.

La demande chez les constructeurs existait, mais elle dépassait l'offre et de loin. Contraints, ces constructeurs étaient prêts à investir dans l'éducation. Les futurs informaticiens se présentèrent, donc, chez eux.

Pour ne pas investir à fonds perdus, il y avait un examen d'entrée, une présélection pour pouvoir s'inscrire à leurs cours prodigués, un peu à la sauvette, dans ces écoles de fortune. Cela faisait sérieux ces examens et cela permettait de départager et de trouver quelques prédispositions très peu définies par manque d'expérience.

Quel genre d'examens pouvait augurer de bons résultats pour cet investissement ? Comment augmenter les chances de succès pour un étudiant, parfois en perdition, recalé dans d'autres voies plus officielles ?

L'examen d'IBM jouait sur la logique, la psychologie avec, en plus, la rapidité des réponses. En une heure, chrono en main, l'examen se déroulait sans relâche dans de grandes classes où toutes les places étaient prises.

Drôle de mise en boîte, cette intelligence réduite à la seule logique et à une compétition avec les secondes comme chef d'orchestre ! La recherche de la bonne personne par l'intermédiaire du fameux QI, était-ce la providence, le calque pour un boulot d'informatique ? Personne n'aurait pu dire ce que constituait un candidat valable, un "client" programmeur, pour une science qui ne disait pas encore son nom. Mais IBM restait la marque numéro un, la référence principale, vu le gap important avec les autres constructeurs. Un ordinateur s'appelait souvent "machine IBM" par extrapolation avec la machine à écrire à boule plus connue.

Passage obligé, on s'y pliait de bonne grâce. La chanson "Quand la musique est bonne" pouvait bien se transformer en "quand la logique est bonne" pour l'occasion.

Avec le recul, si la logique pouvait être considérée comme une base, un départ théorique, elle devait se concrétiser par des cours qui allaient suivre, en cas de succès à ces examens d'entrée, mais ne constituait qu'un croque en jambe, une simple mise en bouche, dans tous les métiers d'informaticien.

N'a pas la passion qui veut de cette inconnue qu'on appelle "logique". N'est pas informaticien génial qui veut, non plus. Gagner de l'argent, le plus rapidement possible pour faire oublier un échec dans un domaine classique, était souvent le désir unique des jeunes qui se pressaient au portillon de ces écoles sans véritable conviction. La fin justifiait les moyens et tout le monde était content. Le besoin de main d'œuvre de manière urgente, d'un côté. Les élèves qui avaient besoin de justifier un besoin de connaissances auprès des parents qui finançaient leurs études, de reconnaissances pour eux-mêmes, sans délais ni orientation professionnelle préalable.

La fibre informatique féminine était quasiment absente, dès le départ. Avait-on entendu que les jobs demandaient un esprit d'analyse, de logique, de précision ? Tout cela était très peu dans les cordes des filles, pensait-on. Elles en avaient probablement peur ou une contre publicité en avait été faite à la base. On chuchotait que le métier demandait le sacrifice d'heures supplémentaires. Que de fantasmes dans l'effervescence, autour de ce phénomène "computer".

Certains constructeurs allaient plus dans le détail pour leurs examens d'acceptation dans l'école. Pour Honeywell Bull, ce furent des sélections longues et très poussées. Univac, un peu moins. Tous examens, bouclés dans une demi-journée. Cette fois, de véritables problèmes étaient posés qui devaient permettre d'apprécier, de manière plus précise, ce que le candidat informaticien avait comme potentiel.

Une fois qualifié, par la suite, l'étudiant prenait place sur les bancs des classes et commençaient l'étude des langages de l'époque du niveau basique aux plus évolués. Cela voulait dire, la logique, la base de savoir ce qu'était une machine, comment cela fonctionnait avec l'assembler, le langage symbolisé, le plus proche de la machine, derrière lequel se réfugiait tout le scénario d'un programme constituaient l'apprentissage structuré et sous le contrôle des fameux "ordinogrammes". Quelques algorithmes de fusions de fichiers, de cumuls de chiffres pour les consolider étaient enseignés. Les algorithmes de tri occupaient les esprits. Ce langage machine était diablement complexe, et sans filets, si ce n'est par le compilateur. La mémoire, il fallait l'adresser, la configurer, par tranches d'adressages en base de registres. Des machines, avec de plus petites mémoires et un processeur tout aussi limité, obligeaient à passer par cette extrémité et prenait encore plus de temps avec plus passe d'assemblage.

Tout l'enseignement se limitait avec la gestion comptable, première consommatrice des heures de processing de ces machines ... à calculer. Les sous-programmes, petits morceaux d'instructions réutilisables avaient vu le jour pour compresser les besoins de fonctionnalités. Un traitement de texte honnête qui dépassait le stade de la machine à écrire, n'était pas encore venu à l'esprit. Le Typp-Ex avait encore de beaux jours de vie devant lui.

En cas d'échec aux examens d'entrée de ces écoles, pour combler et repositionner, on voyait poindre, de plus en plus, d'écoles privées qui, elles, n'allaient pas s'encombrer d'examens de passage, mais seulement de s'assurer les finances de ces sociétés naissantes, des startups, dirions-nous, aujourd'hui. Les professeurs étaient devenus un ensemble de pionniers volontaires, formés par leur seule expérience de quelques mois. Il fallait catégoriser les candidats comme tâche préliminaire : encodeurs, perforatrices, opérateurs ou programmeurs et, bien plus tard, analystes en bout de chaîne.

Arriver au bout, après examens de sortie, signifiait la place assurée avec pont d'or pour l'époque. L'aventure, c'était toujours l'aventure. Elle était, déjà, applaudie même sans preuve. Les places étaient offertes bien avant la demande pour tous les acteurs.

Nous n'étions pas à la chasse aux Mips et aux lumières, mais il fallait remplir les besoins au mieux des disponibilités avec les moyens du bord de l'époque.

Les vocations et l'utilisation des machines pouvaient naître. Des "flibustiers" ou "pirates" avides de bons coups plus ou moins légaux, se présentèrent pour combler la demande forte. Consultants opportunistes, dans un parfait accord avec les règles de l'offre et de la demande, exercèrent, sous une forme de "body shop", par le placement de "spécialistes" dans les sociétés. Spécialistes, payés, rubis sur ongle, à l'heure ou à la journée, sorte d'intérim avant l'heure. Et cela fonctionnait à fond. Les ponts d'or n'étaient pas rares. Les dérapages étaient pourtant programmés dans une telle ambiance d'effervescence. Personne ne s'en émouvait outre mesure, d'ailleurs. Quand la résurgence de Crésus qui transformait tout en or comme liens étaient là, pourquoi devait-on s'inquiéter ?

Bientôt, naissaient, en coulisse, de véritables "pro", des génies de l'informatique, ceux qui y voyaient une filière pour élever la situation à la bonne hauteur des besoins et pour effacer les gourous de l'arnaque. Rationaliser par des outils, fusionner les désirs de tous, étaient la pierre angulaire de leurs actions.

Touche à tout, cette informatique. Le métier de programmeur avait, il faut bien l'avouer, des atouts de "grands". On n'hésitait encore pour l'appeler "programmeur" ou "programmateur" de peur d'être confondu entre professions.

Cette "heureuse" informatiques du passé n'était pas encore considérée comme un outil, mais comme profession à part entière, comme une vocation sacerdotale, parfois. La motivation passait par la passion au détour du chemin sans crier gare pour les accros. Dans ce cas, les heures passées n'avaient plus qu'une importance approximative. Que de nuits se sont comptées dans cette débauche de bons vouloir pour "réussir" avec un certain enthousiasme. Benchmarks, installations sur les systèmes des applications prenaient un temps fou pour les tests. Il fallait à tout prix prouver le bien fondé du choix d'une marque plutôt qu'une autre aux prospects. Les loupiotes de la console servaient d'outil de test et de tracing.

Le progrès et les salaires allaient de pair avec cet acharnement. Échelles parallèles avec des échelons toujours proportionnels aux investissements personnels. Le jeu en valait la chandelle. Il faut bien l'avouer, un certain chantage s'était établi dans les relations employé-patron au niveau des salaires.

Avec ses grandes bécanes, la vie de bureau a complètement changé. Changé ou, peut-être, revenue par un autre moyen vers les "Temps modernes" de Charlot. Dans le fond, nous n'en étions pas tellement éloignés avec les workflows, des JCL, qui s'imposaient de plus en plus comme un travail cadenassé derrière des processus, en chaînes. Processus que l'on se repasse de l'un service à l'autre, en réseau, pour changer, après avoir apporté ses compétences propres sur chacun des maillons. Ils pouvaient suivre les compétences et les expertises ou se perdre en cours de route avec des retours à l'origine pour imperfection. Plus tard, fait nouveau, ces processus ne devaient plus se localiser au même endroit pour fonctionner.

Les « bugs », ces maudites erreurs de programmations, se découvraient à l'usage et plus qu'à la conception. Il fallait toujours rattraper le temps perdu. Échanges de mauvais procédés ou marchés de dupe, avec l'autorisation tacite et la compassion du client. Comme la maintenance faisait aussi partie des contrats, pas de problèmes, chacun assumait en "pompiers programmés".

La complexité et les désirs des clients ne faisaient qu'augmenter dans le même temps. Vu cette complexité accrue, les erreurs de programmation commencèrent à se réfugier derrière une "mauvaise compréhension" du cahier des charges (quand il y en avait) ou d'une difficulté de situer l'envie et la stratégie d'origine du client lui-même. Car lui, bien souvent, ne savait pas non plus comment expliquer son problème avec clarté pour quelqu'un qui ne connaissait pas les termes comptables. La déstandardisassion maintenait le client dans le giron du producteur de programmes. Le besoin de s'entendre était commun. Par-là, le but était atteint, mais c'était dans la douleur.

Les vendeurs de matériel et de forces de travail étaient aussi très contents. Les commissions étaient à la hauteur des ambitions. La grandeur et le poids des machines expliquaient les prix de ventes et les pourcentages de commissions.

Vendait-on au poids ? Non, bien sûr. Attirés par les résultats et les avantages liés aux ventes, il y a eu des transfuges parmi les informaticiens vers la vente. Cela n'a pas toujours été un succès. On pouvait croire que l'option choisie était naturelle. Qui connaît mieux les machines que ceux qui vont dans son "cambouis" ? Pensée toute naturelle. Parmi les nouveaux "chasseur d'or", il y en a eu qui tenaient le tamis et d'autres qui en vendraient l'or. Il ne fallait pas confondre. Être payé à la commission ne faisait pas nécessairement des millionnaires quand on commence par un salaire fixe.

La chasse aux Mips était nécessaire pour les clients et aussi pour les "fourmis programmeuses". Bien rémunérées tant qu'elles prenaient du plomb dans la cervelle car leurs tests dans la vie réelle, valaient aussi leur pesant de cacahuètes en temps et en argent. Des professions de tous les types se sont greffées sur cette manne de potentialités, complètement ignorée par l'utilisateur final d'applications "clé sur porte". Le "time sharing" allait, heureusement, limiter la casse. Le temps machine se payait au tarif horaire cher, mais tant qu'on aime, on ne compte pas.

Les dérives du progrès. Une folie commença à se produire. Pour garder une chance de rester en course, il fallait que le client passe de conversion en conversion de plus en plus vite. Comme on se cherchait en permanence pour réaliser les projets, on ne savait pas vraiment vers où on devait aller, mais il fallait qu'on fasse à ses frais la remise à niveau, poussé dans le dos par les concepteurs de logiciels. Lors des démonstrations, cela semblait valoir la peine de faire le pas vers l'étape suivante. Avait-on eu d'ailleurs vraiment le choix et le temps d'évaluer la connaissance de la version précédente ? Rien n'était moins sûr.

Les conversions s'opéraient dans la douleur et le recueillement, à l'arraché, à force de jours, de semaines, de mois de préparation et d'obligations de continuer à faire "tourner le moulin" en parallèle. Pas moyen de faire marche arrière ou si peu. On essayait de suivre à la trace en espérant qu'une 25ème heure viennent s'ajouter à la journée.

Dans les directions, on était, aussi, très fier de ses investissements, de se balader à proximité des salles machines et des bureaux de développement. Le snobisme s'était emparé des patrons mais aussi des informaticiens développeurs. En haut, on ne savait pas vraiment de quoi on parlait. Dans le bas, on n'était pas avare de renseignements qui devaient montrer l'importance du projet à réaliser. Le partage de l'info n'était pas la préoccupation majeure aux deux extrémités. Vulgariser, personne n'en parlait. Le mystère et les secrets devaient planer pour continuer à exister. Le relationnel, on le voulait au niveau des bases de données mais pas de l'utilisateur ou du demandeur. Les directeurs de l'informatique, les patrons du département de l'informatique, étaient écoutés avec la plus grande attention par la haute direction.

L'effet de mode jouait à plein. Pour maintenir ces secrets de fabrication, il y avait le jargon informatique, voulu ou non. Ce n'était pas un lexique médical mais cela pouvait y ressembler. Car il y avait, dans le même dictionnaire, des synonymes et des dialectes mélangés, dans lesquels mêmes les plus habitués se perdaient, tellement, le métier était en évolution constante. Ce que pouvait réaliser une version d'un software n'était pas permis avec une autre ou en collaboration avec une autre application dite compatible. Dialoguer semblait parfois devenir le chemin de croix entre l'informaticien qui parlait avec des suffixes de numéro de version, avait à mettre en parallèle avec des règles de la comptabilité de professionnels de l'autre partie dont il n'avait jamais entendu parler. Établir un budget et un timing pour une installation d'une application se partageait entre être en dessous de la vérité et se retrouver avec un retard important ou être au-dessus avec des marges surévaluées.

La banalisation des efforts du traitement de l'information a été progressive et bien plus tard. Accompagnée par un éloignement progressif des langages qui partaient du niveau machine en se rapprochant de l'humain, les non-informaticiens se sont mis à rêver qu'ils pouvaient comprendre le déroulement des programmes. Plus vraiment de gourous inviolables, donc. L'Assembler faisait progressivement place au Cobol, à l'ALGOL, au RPG, au Fortran, au Pascal, plus près de l'humain... chacun remplacé en finale par des outils de 3ème et 4ème génération et une cinquième qui n'a jamais pu définir son existence de manière précise. Chacun allait pouvoir y mettre un coup comme apprentis sorciers pour renforcer la force de travail. Du moins le croyait-on.

On semblait parvenir, désormais, à mieux cerner la logique interne sans qualifications trop pointues dans le traitement de l'information. A posteriori, le programme final, conçu par cette voie, ressemblait souvent au Canada Dry, avec de l'alcool qui n'en était pas ou qui manquait de structure et d'expériences comme degrés essentiels pour être bien maintenu avec le plus de sécurité.

On semblait parvenir, désormais, à mieux cerner la logique interne sans qualifications trop pointues dans le traitement de l'information. A posteriori, le programme final, conçu par cette voie, ressemblait souvent au Canada Dry, avec de l'alcool qui n'en était pas ou qui manquait de structure et d'expériences comme degrés essentiels pour être bien maintenu avec le plus de sécurité.

Les spaghettis étaient nés. La maintenance, ce n'était pas l'affaire des concepteurs. Que se passait-il pour corriger l'erreur ? Les professionnels réécrivaient l'ensemble, une nouvelle fois.

Tout le monde profitait de l'informatique, c'était un fait. A des échelons différents, dans lequel rêve et cauchemar se confondaient dans la même ambiance euphorique.

A l'avènement du PC, cela changea un peu plus vite. Les plus doués se limitèrent à leur garage ou à de petits comités d'enthousiastes avec des idées plein les neurones. On allait rationaliser tout cela. Le travail rejoignait le hobby. L'informatique est souvent une "mixture" de bons procédés, d'ingrédients indéfinis à priori. Le génie n'était d'ailleurs pas nécessairement limité à l'invention mais aussi à la détection du meilleur assemblage possible.

Tellement de chemins menaient-ils, encore, à Rome ? Loin d'être garanti sur facture. Pour le particulier, le PC a plutôt servi de tremplin à l'essor des jeux plutôt qu'à servir réellement à la connaissance des sciences.

Des créateurs d'idées, des réalisateurs, des installateurs, des déchiffreurs de résultats, des désinstalleurs dans la panoplie du parfait organisateur des jeux informatiques.

Chacun sa casquette, ornée de bits, de bytes (octets), de mots, comptés en binaire, octal ou hexadécimal. Tout est question de base, dirait le mathématicien, de lecture de dump, les informaticiens.

Quand je vous disais que c'est une foire aux inventions, l'Informatique... avec un grand "I", ce le fut très certainement.

Les nuages arrivaient déjà. Les orages se pointaient à l'horizon. Personne ne s'en doutait encore dans cette fin du 20ème siècle.

Pourtant, ils allaient surprendre subrepticement, insidieusement.

18:18 | Lien permanent | Commentaires (1)

21/11/2008

La Grande Gaufre (03)

Tableau 3: "Le sel, le sucre et le blanc d'œuf"

« Comme la Hongrie, le monde informatique a une langue qui lui est propre. Mais il y a une différence. Si vous restez assez longtemps avec des Hongrois, vous finirez bien par comprendre de quoi ils parlent. », Dave Barry

Après une incursion chez les informaticiens, reprenons le cheminement au niveau périphériques, des "computers" et de ceux qui étaient là, "acting".

Après une incursion chez les informaticiens, reprenons le cheminement au niveau périphériques, des "computers" et de ceux qui étaient là, "acting".

Que serait la gaufre s'il n'y avait le sel, le sucre et le blanc d'œuf ? Dans cet environnement qui gravite autour de l'unité centrale, ce n'était d'ailleurs pas plus calme. Les périphériques avaient aussi pris du poil de la bête.

Une force de calcul, au centre, sans pouvoir donner des ingrédients en "input" ni en ressortir les résultats en "output" n'aurait pas eu beaucoup de sens.

C'est peut-être une occasion d'écraser des préjugés.

Avoir une conception numérique de la résolution d'un problème prend une voie particulière qui ne passe pas par la sensibilité, mais par les dichotomies multiples de résolutions.

Au départ, il y a des données, des datas, que l'on appelle "input".

A l'arrivée, ce sont des résultats à apporter, que l'on assemble dans un "output".

Au milieu un processus intellectuel, qui vise à l'efficacité en temps et en espace.

D'abord, pour communiquer, les cartes perforées en input s'étaient présentées sous deux formats : larges avec 80 colonnes et 12 rangées ou mini réduites par IBM à 96 colonnes dans un deuxième temps. Dix rangées pour les chiffres qui associées avec deux rangées supérieures pouvaient reconstituer l'alphabet complet et les caractères spéciaux. Les opératrices qui perforaient ses cartes, en ont vu défiler devant leurs yeux sans comprendre ce qu'elles encodaient... Un petit coin tronqué pour les repérer et surtout remettre à sa place facilement en cas de "catastrophe" complétait ces cartes qui devaient avoir été construites dans des normes très précises. Ce support permettait de trier les informations et de les sélectionner. Trier ces cartes, une opération dont on n'a plus idée de la méthode, aujourd'hui, cachée derrière des algorithmes très complexes pourtant mais intégrés dans un module de tri qui choisit sa meilleure technique automatiquement. Les cartes, elles, c'était trier colonne par colonne, de droite à gauche pour les chiffres avec deux passages supplémentaires pour l'alphabétique automatiquement rejeté dès le départ. Comme les trous n'étaient pas toujours très précis, les rejets n'étaient pas rares. Un sport qui avait ses spécialistes et ses gaffeurs. Aux jeunes qui étaient assignés à cette tâche, souvent, une mise à l'épreuve des plus "hasardeuses" de trier les cartes sur la couleur leur était demandée. Ce qui se terminait évidemment par un gloussement ironique.

Les bandes magnétiques étaient la voie parallèle. Plus concentrées, plus faciles à transporter, elles n'étaient pas nécessairement plus fiables au départ. Le magnétisme avait de ses secrets de lecture incompréhensibles. Une petite pression de crayon devant la tête de lecture pour "forcer" le passage se révélait souvent nécessaire après des essais à répétition. La fiabilité vint bien plus tard. Le problème au niveau input était ainsi résolu. Trier nécessitait trois bandes de travail et parfois des heures en fonction du nombre d'enregistrements à trier en "x" phases en avant et en arrière. Les bandes avaient un défaut : le manque d'accès direct, ce qu'avait les disques.

Les disquettes, d'abord, les floppy disk (5 1/4 inch) apparurent avec le PC. Très limitées en capacité, ils accédaient néanmoins, en direct, aux données.

Les tambours, eux, allaient faire résonner leurs batteries pour contenir ces précieuses données, une fois enregistrées. Ancêtres des disques durs, ils n'avaient qu'un charme relatif aux oreilles des opérateurs chargés de leur maintenance.

Les imprimantes, les perforatrices à la sortie de la machine et les bandes magnétiques constituaient les seuls moyens de contrôler les résultats, à l'output.

Pour les imprimantes, les rames de papiers attendaient de s'enfiler en accordéon sur leur imprimante en espérant qu'il n'y ait pas de bourrages de papier avec une tendance trop répétitive. Mais les producteurs d'imprimante avaient de l'imagination pour corriger les imprimantes par leurs insatiables envies de manger du papier de plus en plus vite. Des processus d'attraction du papier automatiques aidaient le classement en sortie des imprimantes. La vitesse effaçait tous les griefs. Pas pour les opérateurs qui s'apercevaient après une nuit, que l'imprimante avait décidé de sur-imprimer toutes les lignes sur une seule ligne.

Le marché parallèle des périphériques n'était pas moins juteux et s'évadait un peu trop souvent des constructeurs de l'unité centrale. Acheter la clientèle, les compétences et les techniques des autres compétiteurs pour rester en course se poursuivait à ce "Dallas, cet univers impitoyable" exporté. Le producteur de périphériques MDS avait été racheté dans la foulée par SPERRY. D'autres s'éclataient. Les télécoms attiraient déjà en coulisse comme l'aimant mais n'avait pas encore trouvé sa voie. Internet, s'il a existé assez vite, n'avait pas trouvé la bonne taille de sa Toile pour n'ouvrir les liens plus élargis qu'entre des machines universitaires.

Retour rapide vers les constructeurs des computers et leurs ambitions en accordéon ou en poupées russes :

General Electric s'empara de la société BULL. Celle-ci fut nationalisée par l'État français à la suite de la colère du Général De Gaule qui avait été traumatisé de voir Bull, entreprise française mais sous le contrôle américain. La politique prenait de plus en plus position dans ce champ de mines. On avait, enfin, senti l'importance stratégique de cet outil magique qu'était l'ordinateur.

En 1966, pour cette raison "politique" et de prestige français, se créait CII (C deux I pour les intimes) sous le chapeau du projet IRIS.

En 1973, UNIDATA reproduisait, plus tard, le même phénomène au niveau européen pour contrer les USA. Des "Plan Calcul", "Esprit", "Eureka" allaient également remettre du pouvoir dans les caisses des constructeurs par le domaine public devenu demandeur.

Le but avoué des États était de soutenir leur économie en envoyant le maximum de capacité humaine au travail en échange des contrats signés. Des quotas de 50% de travail effectués dans les frontières des généreux "donateurs" étaient signés entre publics et privés dans une envie commune d'augmenter les emplois. Siemens fut l'un d'entre eux en Belgique. Contrats qui n'étaient, en définitive, que rarement respectés dans leur intégralité. La mise au travail n'était que partielle ou trop temporaire. Les États n'étaient et ne voulaient qu'être des utilisateurs et n'ont jamais été intéressés à investir, eux-mêmes, dans la technologie de l'informatique. La complexité trop évidente faisait peur. Le publique avait lancé la balle au privé, ils devaient continuer à jouer. L'armée américaine, elle, restait en embuscade et n'hésitait pas à investir dans ce "computer" que l'on voyait presque comme remplaçant de l'homme sur les champs de bataille. L'ordinateur analogique aurait pu aller dans ce sens, mais il a été abandonné. Les armes robotisées intéressaient au plus haut point.

Dans le domaine de la gestion et du traitement de l'information civile, une véritable nécropole de l'ambition des marchés informatiques commerciaux allait commencer à vitesse constante dans une véritable jungle où seul le plus fort continua à vivre. Chaque avancée en vitesse représentait souvent un tel progrès qu'il était difficile de ne pas succomber devant les sirènes de la gloire et du prestige. Les potentiels financiers semblaient être là pour réaliser les ponts d'or. Véritables miroirs aux alouettes, en définitive, car la chute des prix commençait. Les investissements s'en ressentaient du côté des constructeurs. Le grand boom était stoppé. Tout devenait compatible. La machine propriétaire cédait la place.

Les échecs allaient souvent changer la donne dans plusieurs entreprises du secteur pour des raisons multiples mais très similaires dans leur processus de recherche de bénéfices. Si le phénomène a existé en même temps dans d'autres secteurs de l'activité humaine, l'informatique y allait en ajoutant une accélération inédite de manière aussi subite qu'incontrôlée.

La firme RCA jeta le gant, la première. Dans la foulée, SPERRY faisait offre pour RCA.

Les autres essayèrent de s'associer pour atténuer les dépenses et pour combiner leurs besoins au niveau de la machine par les spécialistes autour des périphériques. Pour ajuster à la taille des PME, des minis ordinateurs voyaient le jour, chez DEC. (Digital Equipment).

La bureautique était là avec des possibilités qui n'auront de fin de s'étendre bien en dehors des limites de l'imagination et cela comblait déjà toutes les ambitions.

Les micros commençaient leur percée avec des machines rudimentaires, avec des instructions qui ne travaillaient qu'avec l'entité du caractère. Tout transfert de mémoire plus important nécessitant un travail interne en boucle.

Mais, c'est INTEL qui jeta le trouble en créant des microprocesseurs qui permettaient de concevoir le micro-ordinateur pour les plus petites entreprises, longtemps en disgrâce et, plus tard, pour les particuliers. En 1970, chez Intel (Integrated Electronics), Marcian Hoff coinvente le microprocesseur architecturé avec Federico Faggin. Véritable big bang et pavé dans la mare, ce processeur 8088 qui permettait la naissance des PC. On ne croyait pas encore qu'il allait bouleverser complètement la donne pour l'utilisateur commercial mais aussi, et cela est encore plus important, pour le citoyen lambda. Mais c'est le processeur 4004 à base de silicium qui reste considéré comme le premier d'une longue lignée. Il travailla sur circuits intégrés de 2300 transistors à la vitesse de 108 kHz avec 4 bits. Les processeurs les plus évolués actuels avaient 1,3 milliards de transistors et atteignaient une vitesse de cycle de 3,3 MHz.

La relance de la machine à billet pouvait reprendre de plus belle avec ce nouveau départ très prometteur pour les nouveaux constructeurs de ces petites machines encore loin d'être portables. Le chant de signe pour les constructeurs de grosses bécanes, dans le même temps, était programmé. Seuls les serveurs gardaient une chance en concentrant le parc des futurs PC en grappes ou en réseaux.

Le 12 août 1981, l'ordinateur personnel, le PC d'IBM, bouleversa, donc, les habitudes en s'attaquant aux jeunes passionnés. L'Altair, en 1975, avait effleuré les hantises des "bricoleurs". Des marques telles qu'Atari, Comodore 64, sans écran, avaient gagné les marchés ds particuliers. John Opel avait senti qu'il perdait cette part du marché et chargea, en catastrophe, Bill Low de sortir une machine avec écran adressée aux utilisateurs particuliers. La taille d'IBM était un désavantage en manque de souplesse. Le 5150 fut présenté par le patron. Le processeur 8088 à 4,7 MHz, 40K de ROM et 16K de RAM, avec un operating système MSDOS. Un prix de 1.565 $. Ce n'était pas gagné d'avance.

Schneider est arrivé avec son 8086 soi-disant plus performant que le 8088 et surtout moins cher, donc, plus accessible, mais toujours encore bien loin du prix du pain. Les clones étaient nés. Les processeurs qui allèrent l'alimenter devinrent de plus en plus puissants. Les mini ordinateurs avaient senti le vent contraire à la sortie des PC et accusèrent des croissances de ventes nulles.

Le PC jouait des coudes surtout en s'étant associé à un certain Bill Gates et à Paul Allen qui, à eux deux, avaient racheté l'Operating System DOS à base de CPM, à DIGITAL et retravaillé pour les besoins nouveaux et de circonstances sous le nom de MS Dos. Pas besoin de grosses infrastructures pour le software comparativement au hardware qui lui demandait des investissements monstrueux. Un garage suffisait et un peu d'idées...

Le vendre, ensuite, à IBM fut l'étape principale du succès de Bill Gates. IBM en fera le PC Dos, sans contrat d'exclusivité signé. En 1987, l'OS/2 et PS/2 seront des semi-échecs. En 2000, objectif "contrer Microsoft" et pour cela, IBM devint le sponsor de LINUX et de l'Open Source.

Les Serveurs RS/6000, AS400, S/390, Deep Blue, Blue Gen, se succèdent. En 1997, Deep Blue bat Gasparov aux échecs. L'avenir, à la puissance des ordinateurs.

La société IBM emmagasine quelques 37.000 brevets. En 2004, coup de théâtre, le PC IBM est racheté par le chinois Lenovo. Des pertes abyssales, pendant une décennie, ont annoncé la crise. Lou Gerstner reprend la direction de l'entreprise et un quart des effectifs de la grande maison IBM sont licenciés. Il sera remplacé par Pamisano en 2002 avec 400.000 employés dans le monde. L'ambition n'est plus rien que cela : "l'expansion technologique contre la crise".

Pour les États, on y voyait le look et l’aspect tangible, par l'écran interposé, du multimédia, de la CAO, de la PAO et du son, faisaient passer au mieux les images de leurs élus et intéressaient plus pour l'avenir des partis.

Internet ouvrirait, bien plus tard, le véhicule de la pensée du haut vers bas et de bas en haut. Mais, on n'y croyait pas encore en haut lieu. Microsoft se fit distancer sur la Toile.

L'ordi dut se poser une question initiale de base pour le citoyen lambda en dehors du rejeton qui y voyait le seul jeu : à quoi allait bien servir ce nouveau jouet ? On se questionnait et des livres d'initiation sont sortis pour donner quelques idées. Les "clones" vont bouleverser les prix avec une chute abyssale. On les imagine même dans les sociétés connectées entre eux et reliés en réseau avec un "serveur" centralisateur, maître et esclaves. Les années 90 voyaient les mainframes, ces monstres dans les salles climatisées, sortir de l'ambition de prestige des clients. Ils n'existeraient plus que sous le nom de « serveurs ». Plus question de salles climatisées, de faux planchers, d'hygrométrie fastidieuse et de toutes les précautions d'usage. La fiabilité augmentait en dehors de ces contraintes. Ce qui était petit et surtout moins cher et plus facilement agencé dans l'entreprise par l'encombrement, prenait seul l'envolée vers le succès.

Tout était à découvrir. Le langage Basic combla, pour longtemps, les besoins primaires et presque tous les espoirs des plus farfelus en herbe chez les particuliers. Quelques courbes résultats de fonctions, des applications de Bourse, des statistiques, écrire des lettres et mettre en balance ses fins de mois constituaient les seuls débouchés de l'utilisation de ce Personnal Computer à la maison. La convivialité n'y était pas encore, au départ. Les crashes systèmes avec l'écran bleu étaient monnaie courante. En 1963, Douglas Engelbart avait inventé la souris.

La convivialité et la fiabilité allaient se penser, en parallèle, chez APPLE, avec les Mackintosh en copiant les icônes de XEROX. La souris fut utilisée pour la première fois sur cette machine. Toucher l'information désirée en oubliant les touches du clavier, un progrès génial. En 1983, Steve Jobs, sur une idée de Jef Reskin, lance Lisa, une machine lourde mais déjà révolutionnaire. Son prix actualisé à 22.000 euros est resté trop prohibitif. Le 24 janvier 1984, le premier Mac, avec un écran monochrome de 9 pouces, un lecteur de disquette de 3,5 pouces et une souris, et ce fut l'envol. La légende était née. En 1987, ce fut le Mac II. En 1991, le Powerbook, portable, compact. Un désaccord avec John Scutley pousse Steve Jobs vers la sortie. Celui-ci fonde NeXt en 1989. La période de 1993 à 1997, Apple entre en errance commerciale. NeXt est racheté en 1996 pour avaler, du même coup, son OS NexTSTEP qui se retrouvera dans le Mac OSX. Retour de Steve Jobs. En 1998, avec iMac, iBook, en 1999, retour du succès. En 2006, le processeur Intel prend la place du Motorola. Du coup, l'Apple rejoint le PC et s'intègre en gardant la partie émergeante noble du PC, la beauté du software. iPod et autres "i" complètent (prononcez "aille").

Une véritable suprématie sur la convivialité que la société maintient encore aujourd'hui, malgré un risque important de disparition et de dépose de bilan pendant un temps de l'histoire. La fenêtre sur le monde, le fameux "Windows" s'attaqua à rendre, avec beaucoup de retard, plus convivial leur DOS en s'y inspirant fortement. La souris pour pointer une donnée sur l'écran, sortait de son trou pour ne plus jamais y rentrer. Seul, un marketing très efficace permit de battre les compétiteurs. Apple sur les genoux, Microsoft voyant son intérêt dans la concurrence et pour prouver sa bonne volonté de ne pas envahir le marché, renfloua les caisses en rachetant des actions Apple. C'est le 20 novembre 1985 que Microsoft lançait Windows 1.0. Il n'eut un succès commercial qu'à la version 3. En 1995, Windows 95 le rendait plus sûr, plus stable, mais en y arrivant à coup de correction pendant l'exploitation. Le moteur professionnel de Windows NT se greffa dans la version Windows 2000. Mais c'est la version XP qui resta le phare de la marque de 2001 à 2007. L'usine à gaz de Vista n'a été effacée dans les mémoires qu'avec Windows 7.

Windows ne fera pourtant que "personnaliser" ce "computer", adressé au commun des mortels, pour en camoufler la complexité toujours présente derrière des filtres cachés des programmes. En 1984, Microsoft rend la souris optique pour ne plus avoir à nettoyer les contacts trop sensibles à la poussière. Le Blue track poussera plus loin l'insensibilité à l'environnement par le laser et l'optique. Récemment Apple rend sa souris magique. Sans bouton, lisse, complètement tactile, encore plus, conviviale et instinctif.

Vite dit. Sa maîtrise se montre plus délicate et passer d'une photo à l'autre laissera rêveur à la pensée de la bonne vieille roulette de défilement.

Marché qui croit de manière importante et qui ne trouve un parallèle qu'avec l'écran tactile lui-même. Tâchez d'avoir des doigts précis et sans tremblement. Lavez-vous aussi les doigts avant utilisation pour ne pas vous rendre votre écran illisible.

Commander votre ordi par la voix, une autre méthode à ses débuts dans la version XP.

Illusions et vanités de ces non-avertis que tout cela ne serait qu'une montée en puissance sans conséquences sur le long terme. La complexité s'était découverte progressivement dans la douleur, elle allait se poursuivre sur d'autres voies à un autre étage du savoir, pas moins avares de contraintes. Devant l'étendue des connaissances nécessaires, se découvrir, tout à coup, "informaticien hors circuit" eut le malheur de faire mal à plus d'un d'entre eux. Le stade de contrôler cette armada de puissance sous forme binaire très peu attachée à s’associer à l'esprit humain, était dépassé.

Illusions et vanités de ces non-avertis que tout cela ne serait qu'une montée en puissance sans conséquences sur le long terme. La complexité s'était découverte progressivement dans la douleur, elle allait se poursuivre sur d'autres voies à un autre étage du savoir, pas moins avares de contraintes. Devant l'étendue des connaissances nécessaires, se découvrir, tout à coup, "informaticien hors circuit" eut le malheur de faire mal à plus d'un d'entre eux. Le stade de contrôler cette armada de puissance sous forme binaire très peu attachée à s’associer à l'esprit humain, était dépassé.

Les mutations se poursuivent désormais dans ce qui est de plus en plus "petit" mais pas nécessairement "gentil". Les premiers sacrifiés furent les encodeurs et surtout encodeuses. Ceux-ci encodaient en aveugles sur des machines. Perforatrices, Interprètes, Vérificatrices. N'était-ce pas le sigle choisi ? N'était-on pas dans le domaine des VIP à l'envers ? On se passait alors la main pour vérifier dans un ré-encodage et bloquer la chaîne en cas de "mismatch".

Décentralisés, l'encodage prenait du galon derrière la protection de programmes qui vérifiaient en arrière-plan, les données entrées avec les bases de données de référence par les utilisateurs eux-mêmes. Cela allait moins vite, mais au moins cela nécessitait moins de ré-encodage. Mais la confiance devait régner puisque le programme était censé contrôler. Les "check digits" pour les nombres comme les comptes en banque sont tellement providentiels !

Les opérateurs voyaient aussi leur fonction rétrécir à des tâches de contrôle de la console et non plus à introduire les bandes magnétiques dans leurs armoires. Cette fonction était orchestrée de plus en plus par des robots.

Les robots n'allaient dès lors plus s'endormir dans beaucoup d'autres fonctions. Un peu d'huile et une révision annuelle leur suffisent à ces robots providentiels. Le travail d'opérateur se rétrécissait dans le même temps à celui de pupitreur. L'automatisation de chargement des périphériques se poursuivait.

Cette histoire fut, incontestablement, une « Grande Trappe » et pas uniquement au niveau matériel. Dans l'effervescence, le jeu de chaise musicale, au niveau des "seconds couteaux" du management, continuait. La recherche du "comment être plus catholique que le pape" se jouait, avec les coudes, en passant par des tours de passe-passe dans lesquels la politique n'était pas très éloignée.

En fait, une bonne mise en bouche pour la vraie « Grande Gaufre » qui va prendre sa suite.

18:17 | Lien permanent | Commentaires (0)

20/11/2008

La Grande Gaufre (04)

Tableau 4: « Compatible » ou « Clone » ? Une question à « bulle »

"Nous ne pouvons pas prédire où nous conduira la Révolution Informatique. Tout ce que nous savons avec certitude, c'est que, quand on y sera enfin, on n'aura pas assez de RAM. », Dave Barry"

Désormais, la fuite en avant du progrès se concevait de plus en plus dans le temporaire. Match de donnant-donnant, avec une volonté de presser l'accélérateur par une clientèle bureaucratique, coincé entre baisses de prix et frein pour garder une chance de remplir encore les caisses. Dans cette course, vu le dilemme, les besoins augmentant de manière exponentielle, les clients s'étaient mis à tester eux-mêmes les machines (le hardware) et les programmes (le software) à la place des fournisseurs.

Désormais, la fuite en avant du progrès se concevait de plus en plus dans le temporaire. Match de donnant-donnant, avec une volonté de presser l'accélérateur par une clientèle bureaucratique, coincé entre baisses de prix et frein pour garder une chance de remplir encore les caisses. Dans cette course, vu le dilemme, les besoins augmentant de manière exponentielle, les clients s'étaient mis à tester eux-mêmes les machines (le hardware) et les programmes (le software) à la place des fournisseurs.

Les compatibles se retrouvaient de plus en plus les particuliers et devenaient les « clones ». Enfin, presque. Le pourcentage de ressemblance le plus élevé donnait le plus de bons points. Rester standard, en ligne, au moindre coût, se singer pour continuer à vivre, toutes les solutions pour avoir une chance de participer à cet engouement. Toute l'originalité se retrouvait dans la compatibilité avec la concurrence et non plus dans le progrès. Question à bulle sur une ligne de l'évolution.

Mais, au fait, qu'est-ce qu'un programme, un logiciel ou un software ? Cette marchandise "douce" était-elle si "molle" qu'on le prétend ?

On pourrait dire, qu'un programme, c'est un livre fonctionnel d'utilité publique, codé avec des injonctions, conditionnées, séquentielles ou en bulles. Écrit dans une langue précisée au départ, avec une préface d'initialisation, des chapitres imbriqués en spirales imbriquées, descendantes et remontantes pour traiter une fiche insérée dans une ou plusieurs tables. Le dernier chapitre demanderait de relire le premier en boucle en y associant la fiche suivante et cela jusqu'à la dernière. Une postface fermerait le bouquin automatiquement, une fois qu'une condition est remplie.

Pour mettre cela, en pratique, il y a sa mémoire virtuelle qui permet, en fonction de sa taille, de "tourner" en parallèle plusieurs "livres" en accordant des priorités spécifiques à chacun. Comme il y a des moments creux pour tourner les pages, actionnées par les périphériques, la multiprogrammation permet, en effet, d'utiliser le cerveau avec le maximum d'efficacité. Comme cela ne suffit pas encore, il y a eu le "Time-Sharing" pour combler les "trous" et le temps perdu à rêver retrouvé par le "Real Time". Toujours et de plus en plus dans l'esprit de "Time is money".

Quelle est l'histoire du software, du moins, en un survol ?

L'ENIAC, au départ, se programmait avec des fils électriques enfichés dans des plots pour réaliser des opérations.

L'ENIAC, au départ, se programmait avec des fils électriques enfichés dans des plots pour réaliser des opérations.